这篇教程Transformer的基本原理写得很实用,希望能帮到您。

Transformer的基本原理

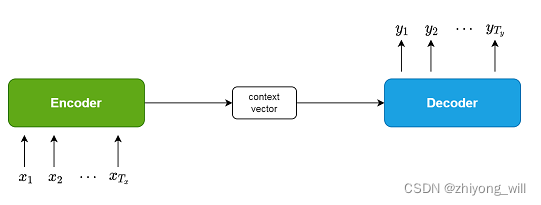

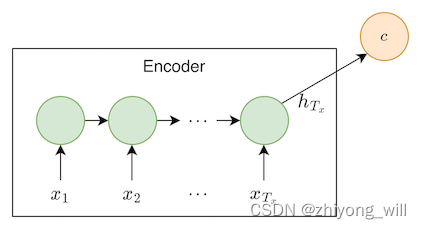

1. Seq2Seq框架 1.1. Seq2Seq框架概述 Seq2Seq[1]框架最初是在神经机器翻译(Neural Machine Translation,NMT)领域中提出,用于将一种语言(sequence)翻译成另一种语言(sequence)。其结构如下图所示:

在Seq2Seq框架中包含了Encoder和Decoder两个部分。在Encoder阶段,通过神经网络将原始的输入{ x 1 , x 2 , ⋯ , x T x } { x 1 , x 2 , ⋯ , x T x } { c 1 , c 2 , ⋯ , c l } { c 1 , c 2 , ⋯ , c l } { y 1 , y 2 , ⋯ , y T y } { y 1 , y 2 , ⋯ , y T y }

1.2. 建模方法 在Encoder和Decoder部分,需要模型能够对时序数据建模,在NLP中,通常使用两种方式对时序数据建模,一种是以RNN[2],LSTM[3]为主的建模方法;另一种是以CNN[4],[5]为主的建模方法。

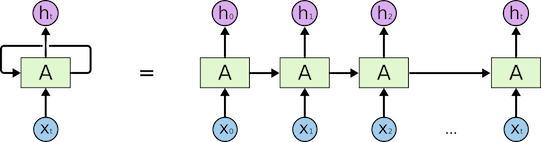

以RNN为例,其基本机构如下图所示:

在基于RNN的建模方法中,t t t − 1 t − 1 t t

h t = f ( U h t − 1 + W x t + b ) h t = f ( U h t − 1 + W x t + b )

在RNN的基础上衍生出很多优化的方案,如对于长距离依赖问题的优化,提出了LSTM以及GRU等模型;对于单向建模能力的问题,提出了双向的RNN模型,提升了对时序数据的建模能力。以简单的RNN为例,从上可以看出,RNN最大的问题是不容易并行化。因为t t t − 1 t − 1 t − 1 t − 1

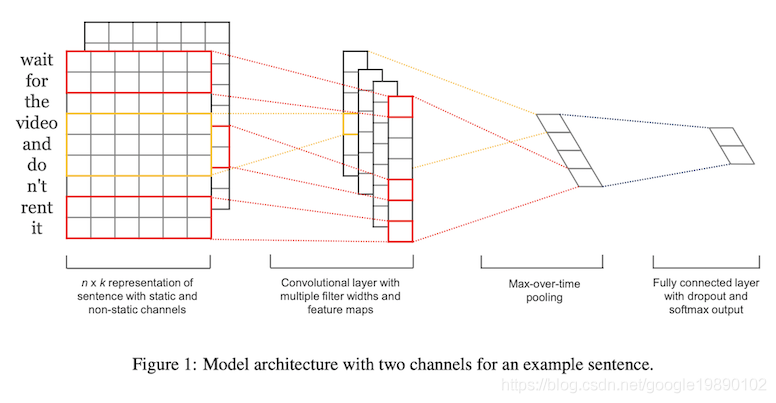

第二种是CNN的建模方法,以TextCNN[4],[5]模型为例:

以最外层的红色为例,设置不同的filter的大小N N N N

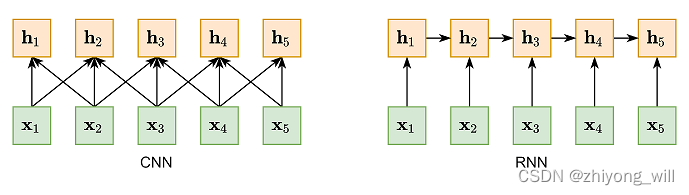

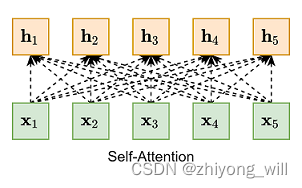

从图中可以看出,CNN和RNN都是对变长序列的一种“局部编码”:卷积神经网络是基于N-gram的局部编码;而对于循环神经网络,由于梯度消失等问题也只能建立短距离依赖。要解决这种短距离依赖的“局部编码”问题,建立输入序列之间的长距离依赖关系,可以使用以下两种方法:一种方法是增加网络的层数,通过一个深层网络来获取远距离的信息交互,另一种方法是使用全连接网络[6]。全连接网络如下图所示:

然而,全连接网络虽然可以对远距离依赖建模,但是无法处理变长的输入序列,同时,在全连接网络中,缺失了词之间的顺序信息。不同的输入长度,其连接权重的大小也是不同的。

综上,基于RNN,CNN以及全连接网络建模方法存在着以下的问题:

长距离依赖问题(RNN,CNN)

并行问题(RNN)

变长输入问题,词序信息问题(全连接网络)

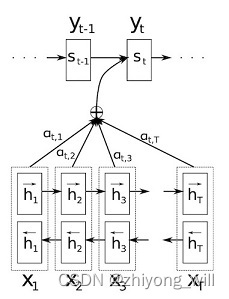

1.3. Self-Attention 为了能提升Seq2Seq框架的性能,在Seq2Seq框架中引入了Attention机制[7],Attention机制通过对训练数据的学习,对其输入x x

其中,Attention的计算体现在针对不同的Decoder输出y t y t c t c t y t y t

y t = f ( y t − 1 , s t − 1 , c t ) y t = f ( y t − 1 , s t − 1 , c t )

其中,c t c t

c i = ∑ j = 1 T x α i j h j c i = j = 1 ∑ T x α ij h j

其中,α i j α ij

α i j = e x p ( e i j ) ∑ k = 1 T x e x p ( e i k ) α ij = ∑ k = 1 T x e x p ( e ik ) e x p ( e ij )

其中,e i j e ij i i s i − 1 s i − 1 j j h j h j

e i j = a ( s i − 1 , h j ) = v a T t a n h ( W a s i − 1 + U a h j ) e ij = a ( s i − 1 , h j ) = v a T t anh ( W a s i − 1 + U a h j )

上述的公式也表示了一般性的Attention的计算过程,即:

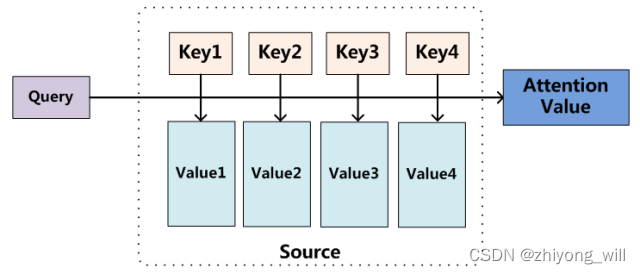

计算Attention得分:e i = a ( u , v i ) e i = a ( u , v i )

归一化:α i = e i ∑ i e i α i = ∑ i e i e i

输出:c = ∑ i α i v i c = ∑ i α i v i

通常,一个Attention函数可以被描述成一个映射,其中该映射的输入是一个query和一组key-value对,其具体过程可以通过如下的图表示[8]:

与上式对应,Query为上式中的u u v i v i v i v i

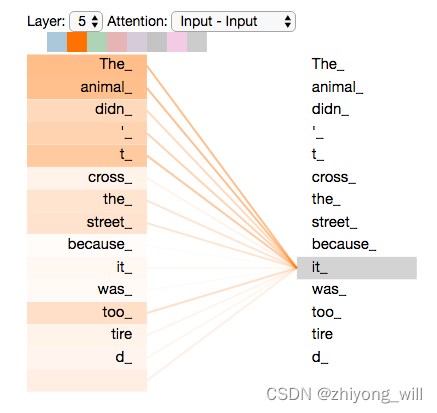

以右侧的词为Query,Query与左侧的每一个Key计算Attention得分,从上图可以看出,Query(it_)与Key(animal_)的Attention得分比较大。Self-Attention的一般形式为:s o f t m a x ( X X T ) X so f t ma x ( X X T ) X

与上述全连接不同的是,Self-Attention不再受变长输入的影响。

Self-Attention的提出解决了传统RNN模型的长距离依赖,不易并行的问题。虽然Self-Attention有这些优点,但是基本的Self-Attention本身并不能捕获词序信息,Google于2017年提出了解决Seq2Seq问题的Transformer模型[10],用Self-Attention的结构完全代替了传统的基于RNN的建模方法,同时在Transformer的模块中加入了词序的信息,最终在翻译任务上取得了比RNN更好的成绩。

在Transformer中依旧保留了Seq2Seq的Encoder+Decoder框架,在Encoder阶段对源文本编码,生成Embedding,记为c c y 1 , y 2 , ⋯ , y t − 1 y 1 , y 2 , ⋯ , y t − 1 y t y t

y t = f ( y t ∣ y 1 , y 2 , ⋯ , y t − 1 , c ) y t = f ( y t ∣ y 1 , y 2 , ⋯ , y t − 1 , c )

对于传统不带Attention的Seq2Seq框架中,Encoder阶段生成Embedding是固定不变的,如下图所示:

对于带有Attention的Seq2Seq框架中,Encoder阶段生成Embedding会根据当前需要预测的值计算一个动态的Embedding,具体如下图所示:

对于Transformer框架中的Encoder,会采用第二种方案。

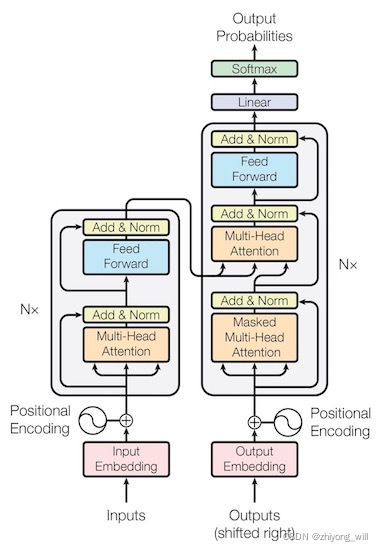

2. 算法原理 Transformer的网络结构如下图所示:

和大多数的Seq2Seq模型一样,在Transformer的结构中,同样是由Encoder(上图中的左侧部分)和Decoder(上图中的右侧部分)两个部分组成。以TensorFlow Core [11]的代码讲解为例子,帮助理解Transformer的整个结构。

2.1. Encoder Encoder部分的结构如下图所示:

在Encoder部分,通过堆叠多个特定模块(如图中Nx部分),在文章[10]中,选择N = 6 N = 6

class Encoder ( tf. keras. layers. Layer) :

def __init__ ( self, num_layers, d_model, num_heads, dff, input_vocab_size,

maximum_position_encoding, rate= 0.1 ) :

super ( Encoder, self) . __init__( )

self. d_model = d_model

self. num_layers = num_layers

self. embedding = tf. keras. layers. Embedding( input_vocab_size, d_model)

self. pos_encoding = positional_encoding( maximum_position_encoding,

self. d_model)

self. enc_layers = [ EncoderLayer( d_model, num_heads, dff, rate)

for _ in range ( num_layers) ]

self. dropout = tf. keras. layers. Dropout( rate)

def call ( self, x, training, mask) :

seq_len = tf. shape( x) [ 1 ]

x = self. embedding( x)

x *= tf. math. sqrt( tf. cast( self. d_model, tf. float32) )

x += self. pos_encoding[ : , : seq_len, : ]

x = self. dropout( x, training= training)

for i in range ( self. num_layers) :

x = self. enc_layers[ i] ( x, training, mask)

return x

注:在文献[10]中提到在Embedding层,乘以权重d m o d e l d m o d e l

2.1.1. 输入 在Transformer中摒弃了RNN的模型,使用基于Self-Attention模型,相比于RNN模型,基于Self-Attention的模型能够缓解长距离依赖以及并行的问题,然而,一般的Self-Attention模型中是无法对词序建模的,词序对于文本理解是尤为重要的,因此在文章[10]中,作者提到了两种位置编码(Positional Encoding)方法,然后将词的Embedding和位置的Embedding相加,作为最终的输入Embedding。两种位置编码分别为:

用不同频率的sin和cos函数计算

学习出Positional Embedding

通过经过实验发现两者的结果一样,最终作者选择了第一种方法:

P E ( p o s , 2 i ) = sin ( p o s / 100 0 2 i / d m o d e l ) P E ( p os , 2 i ) = sin ( p os /100 0 2 i / d m o d e l )

P E ( p o s , 2 i + 1 ) = cos ( p o s / 100 0 2 i / d m o d e l ) P E ( p os , 2 i + 1 ) = cos ( p os /100 0 2 i / d m o d e l )

位置编码的代码在文献[11]中为:

def get_angles ( pos, i, d_model) :

angle_rates = 1 / np. power( 10000 , ( 2 * ( i// 2 ) ) / np. float32( d_model) )

return pos * angle_rates

def positional_encoding ( position, d_model) :

angle_rads = get_angles( np. arange( position) [ : , np. newaxis] ,

np. arange( d_model) [ np. newaxis, : ] ,

d_model)

angle_rads[ : , 0 : : 2 ] = np. sin( angle_rads[ : , 0 : : 2 ] )

angle_rads[ : , 1 : : 2 ] = np. cos( angle_rads[ : , 1 : : 2 ] )

pos_encoding = angle_rads[ np. newaxis, . . . ]

return tf. cast( pos_encoding, dtype= tf. float32)

通过原始词向量和位置向量相加,便得到了最终的带有位置信息的词向量。

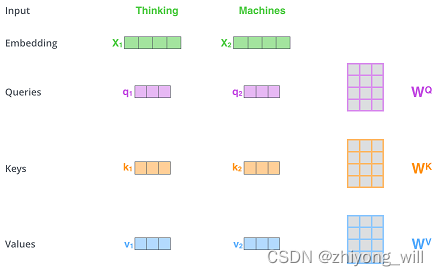

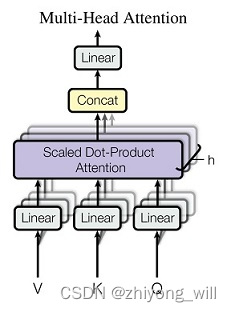

2.2.2. Multi-Head Self-Attention 得到了词向量的序列后,假设为X X Q Q K K V V

这里使用线性变换得到Q Q K K V V

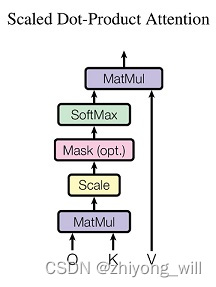

在Transformer中,使用的是Scaled Dot-Product Attention,其具体计算方法为:

A t t e n t i o n ( Q , K , V ) = s o f t m a x ( Q K T d k ) V A tt e n t i o n ( Q , K , V ) = so f t ma x ( d k

Q K T ) V

对于1 d k d k

1

引参考文献[11] :假设Q和K的均值为0,方差为1。它们的矩阵乘积将有均值为0,方差为d k d k d k d k

计算过程可由下图表示:

Scaled Dot-Product Attention模块的代码在文献[11]中为:

def scaled_dot_product_attention ( q, k, v, mask) :

"""计算注意力权重。

q, k, v 必须具有匹配的前置维度。

k, v 必须有匹配的倒数第二个维度,例如:seq_len_k = seq_len_v。

虽然 mask 根据其类型(填充或前瞻)有不同的形状,

但是 mask 必须能进行广播转换以便求和。

参数:

q: 请求的形状 == (..., seq_len_q, depth)

k: 主键的形状 == (..., seq_len_k, depth)

v: 数值的形状 == (..., seq_len_v, depth_v)

mask: Float 张量,其形状能转换成

(..., seq_len_q, seq_len_k)。默认为None。

返回值:

输出,注意力权重

"""

matmul_qk = tf. matmul( q, k, transpose_b= True )

dk = tf. cast( tf. shape( k) [ - 1 ] , tf. float32)

scaled_attention_logits = matmul_qk / tf. math. sqrt( dk)

if mask is not None :

scaled_attention_logits += ( mask * - 1e9 )

attention_weights = tf. nn. softmax( scaled_attention_logits, axis= - 1 )

output = tf. matmul( attention_weights, v)

return output, attention_weights

通过多个Scaled Dot-Product Attention模块的组合,就形成了Multi-Head Self-Attention,其过程如下图所示:

其过程可以表示为:

M u l t i H e a d ( Q , K , V ) = C o n c a t ( h e a d 1 , ⋯ , h e a d h ) W o M u lt i He a d ( Q , K , V ) = C o n c a t ( h e a d 1 , ⋯ , h e a d h ) W o

其中,每一个h e a d i h e a d i h h

Multi-head Attention模块的代码在文献[11]中为:

class MultiHeadAttention ( tf. keras. layers. Layer) :

def __init__ ( self, d_model, num_heads) :

super ( MultiHeadAttention, self) . __init__( )

self. num_heads = num_heads

self. d_model = d_model

assert d_model % self. num_heads == 0

self. depth = d_model // self. num_heads

self. wq = tf. keras. layers. Dense( d_model)

self. wk = tf. keras. layers. Dense( d_model)

self. wv = tf. keras. layers. Dense( d_model)

self. dense = tf. keras. layers. Dense( d_model)

def split_heads ( self, x, batch_size) :

"""分拆最后一个维度到 (num_heads, depth).

转置结果使得形状为 (batch_size, num_heads, seq_len, depth)

"""

x = tf. reshape( x, ( batch_size, - 1 , self. num_heads, self. depth) )

return tf. transpose( x, perm= [ 0 , 2 , 1 , 3 ] )

def call ( self, v, k, q, mask) :

batch_size = tf. shape( q) [ 0 ]

q = self. wq( q)

k = self. wk( k)

v = self. wv( v)

q = self. split_heads( q, batch_size)

k = self. split_heads( k, batch_size)

v = self. split_heads( v, batch_size)

scaled_attention, attention_weights = scaled_dot_product_attention(

q, k, v, mask)

scaled_attention = tf. transpose( scaled_attention, perm= [ 0 , 2 , 1 , 3 ] )

concat_attention = tf. reshape( scaled_attention,

( batch_size, - 1 , self. d_model) )

output = self. dense( concat_attention)

return output, attention_weights

2.2.3. Layer Normalization Layer Normalization是针对每条样本进行归一化,可以对Transformer学习过程中由于Embedding累加可能带来的“尺度”问题加以约束,相当于对表达每个词一词多义的空间加以约束,有效降低模型方差。在TF中可以使用tf.keras.layers.LayerNormalization()函数直接实现Layer Normalization功能。在Transformer中,Layer Normalization是对残差连接后的结果进行归一化,具体公式如下所示:

L a y e r N o r m ( x + S u b l a y e r ( x ) ) L a yer N or m ( x + S u b l a yer ( x ) )

2.2.4. Position-wise FFN Position-wise Feed Forward Network就是一个全连接网络,在Transformer中,这个部分包含了两个FFN网络,可以由下述的公式表示:

F F N ( x ) = max ( 0 , x W 1 + b 1 ) W 2 + b 2 FFN ( x ) = max ( 0 , x W 1 + b 1 ) W 2 + b 2

Position-wise FFN模块的代码在文献[11]中为:

def point_wise_feed_forward_network ( d_model, dff) :

return tf. keras. Sequential( [

tf. keras. layers. Dense( dff, activation= 'relu' ) ,

tf. keras. layers. Dense( d_model)

] )

组合上述的多个部分,最终形成了Encoder模块部分,其代码在文献[11]中为:

class EncoderLayer ( tf. keras. layers. Layer) :

def __init__ ( self, d_model, num_heads, dff, rate= 0.1 ) :

super ( EncoderLayer, self) . __init__( )

self. mha = MultiHeadAttention( d_model, num_heads)

self. ffn = point_wise_feed_forward_network( d_model, dff)

self. layernorm1 = tf. keras. layers. LayerNormalization( epsilon= 1e - 6 )

self. layernorm2 = tf. keras. layers. LayerNormalization( epsilon= 1e - 6 )

self. dropout1 = tf. keras. layers. Dropout( rate)

self. dropout2 = tf. keras. layers. Dropout( rate)

def call ( self, x, training, mask) :

attn_output, _ = self. mha( x, x, x, mask)

attn_output = self. dropout1( attn_output, training= training)

out1 = self. layernorm1( x + attn_output)

ffn_output = self. ffn( out1)

ffn_output = self. dropout2( ffn_output, training= training)

out2 = self. layernorm2( out1 + ffn_output)

return out2

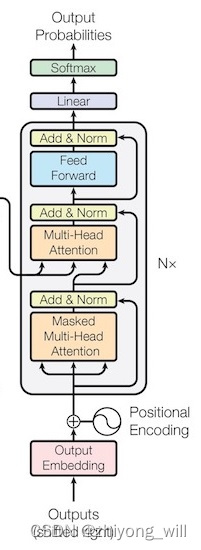

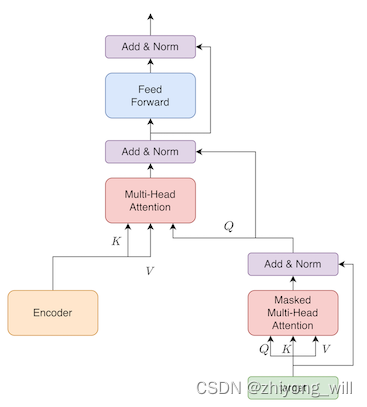

2.2. Decoder Decoder部分的结构如下图所示:

在Decoder部分,通过堆叠多个特定模块(如图中Nx部分),在文章[10]中,选择N = 6 N = 6

增加了Masked Multi-Head Self-Attention这个sub-layer

Multi-Head Self-Attention的输入不一样,在Encoder中,Q Q K K V V Q Q K K V V

Decoder部分的代码在参考文献[11]中如下所示:

class Decoder ( tf. keras. layers. Layer) :

def __init__ ( self, num_layers, d_model, num_heads, dff, target_vocab_size,

maximum_position_encoding, rate= 0.1 ) :

super ( Decoder, self) . __init__( )

self. d_model = d_model

self. num_layers = num_layers

self. embedding = tf. keras. layers. Embedding( target_vocab_size, d_model)

self. pos_encoding = positional_encoding( maximum_position_encoding, d_model)

self. dec_layers = [ DecoderLayer( d_model, num_heads, dff, rate)

for _ in range ( num_layers) ]

self. dropout = tf. keras. layers. Dropout( rate)

def call ( self, x, enc_output, training,

look_ahead_mask, padding_mask) :

seq_len = tf. shape( x) [ 1 ]

attention_weights = { }

x = self. embedding( x)

x *= tf. math. sqrt( tf. cast( self. d_model, tf. float32) )

x += self. pos_encoding[ : , : seq_len, : ]

x = self. dropout( x, training= training)

for i in range ( self. num_layers) :

x, block1, block2 = self. dec_layers[ i] ( x, enc_output, training,

look_ahead_mask, padding_mask)

attention_weights[ 'decoder_layer{}_block1' . format ( i+ 1 ) ] = block1

attention_weights[ 'decoder_layer{}_block2' . format ( i+ 1 ) ] = block2

return x, attention_weights

最终,在Encoder阶段,会针对输入中的每一个词产出一个Embedding表示,正如上述代码中的x的大小为[target_seq_len, d_model]。

2.2.1. Decoder部分的输入 Decoder部分的作用是在t t t t t t

x = self. embedding( x)

x *= tf. math. sqrt( tf. cast( self. d_model, tf. float32) )

x += self. pos_encoding[ : , : seq_len, : ]

2.2.2. Masked Multi-Head Self-Attention Masked是Transformer中很重要的概念,其实在Transformer中存在两种Mask。Mask的含义是掩码,它能掩藏某些值,使得模型在参数更新时对模型掩藏。Transformer中包含了两种Mask,分别是padding mask和sequence mask。其中,padding mask在所有的Scaled Dot-Product Attention里面都需要用到,而sequence mask只有在Decoder的Masked Multi-Head Self-Attention里面用到。

Masked Language Model:即对文本中随机掩盖(mask)部分词,并通过训练语言模型,将masked掉的词填充好,以此训练语言模型。

对于输入序列都要进行padding补齐,也就是说设定一个统一的句子长度N N N N 0 0 N N N N 0 0 1 1 0 0

def create_padding_mask ( seq) :

seq = tf. cast( tf. math. equal( seq, 0 ) , tf. float32)

return seq[ : , tf. newaxis, tf. newaxis, : ]

在Self-Attention的计算过程中,对于mask为1 1 0 0 scaled_dot_product_attention函数中所示:

if mask is not None :

scaled_attention_logits += ( mask * - 1e9 )

sequence mask是为了使Decoder模块不能看见未来的信息。在Decoder模块中,希望在t t t t t t t t 0 0

def create_look_ahead_mask ( size) :

mask = 1 - tf. linalg. band_part( tf. ones( ( size, size) ) , - 1 , 0 )

return mask

两个部分的mask组合在一起,在参考文献[11]中的代码如下所示:

def create_masks ( inp, tar) :

enc_padding_mask = create_padding_mask( inp)

dec_padding_mask = create_padding_mask( inp)

look_ahead_mask = create_look_ahead_mask( tf. shape( tar) [ 1 ] )

dec_target_padding_mask = create_padding_mask( tar)

combined_mask = tf. maximum( dec_target_padding_mask, look_ahead_mask)

return enc_padding_mask, combined_mask, dec_padding_mask

2.2.3. Decoder的核心部分 对于Decoder的核心部分,包含了N x N x

对于Masked Multi-Head Attention,其输入为target的Embedding与Position Embedding的和,其输出作为Multi-Head Attention的输入Q Q K K V V t t t t t t

class DecoderLayer ( tf. keras. layers. Layer) :

def __init__ ( self, d_model, num_heads, dff, rate= 0.1 ) :

super ( DecoderLayer, self) . __init__( )

self. mha1 = MultiHeadAttention( d_model, num_heads)

self. mha2 = MultiHeadAttention( d_model, num_heads)

self. ffn = point_wise_feed_forward_network( d_model, dff)

self. layernorm1 = tf. keras. layers. LayerNormalization( epsilon= 1e - 6 )

self. layernorm2 = tf. keras. layers. LayerNormalization( epsilon= 1e - 6 )

self. layernorm3 = tf. keras. layers. LayerNormalization( epsilon= 1e - 6 )

self. dropout1 = tf. keras. layers. Dropout( rate)

self. dropout2 = tf. keras. layers. Dropout( rate)

self. dropout3 = tf. keras. layers. Dropout( rate)

def call ( self, x, enc_output, training,

look_ahead_mask, padding_mask) :

attn1, attn_weights_block1 = self. mha1( x, x, x, look_ahead_mask)

attn1 = self. dropout1( attn1, training= training)

out1 = self. layernorm1( attn1 + x)

attn2, attn_weights_block2 = self. mha2(

enc_output, enc_output, out1, padding_mask)

attn2 = self. dropout2( attn2, training= training)

out2 = self. layernorm2( attn2 + out1)

ffn_output = self. ffn( out2)

ffn_output = self. dropout3( ffn_output, training= training)

out3 = self. layernorm3( ffn_output + out2)

return out3, attn_weights_block1, attn_weights_block2

2.3. 模型训练 有了上述的Encoder和Decoder模块,对于一个完整的Seq2Seq框架,需要综合这两个部分的逻辑,完整的Transformer的代码在参考文献[11]为:

class Transformer ( tf. keras. Model) :

def __init__ ( self, num_layers, d_model, num_heads, dff, input_vocab_size,

target_vocab_size, pe_input, pe_target, rate= 0.1 ) :

super ( Transformer, self) . __init__( )

self. encoder = Encoder( num_layers, d_model, num_heads, dff,

input_vocab_size, pe_input, rate)

self. decoder = Decoder( num_layers, d_model, num_heads, dff,

target_vocab_size, pe_target, rate)

self. final_layer = tf. keras. layers. Dense( target_vocab_size)

def call ( self, inp, tar, training, enc_padding_mask,

look_ahead_mask, dec_padding_mask) :

enc_output = self. encoder( inp, training, enc_padding_mask)

dec_output, attention_weights = self. decoder(

tar, enc_output, training, look_ahead_mask, dec_padding_mask)

final_output = self. final_layer( dec_output)

return final_output, attention_weights

3. 总结 Transformer对基于递归神经网络RNN的Seq2Seq模型的巨大改进。在文本序列的学习中能够更好的提取文本中的信息,在Seq2Seq的任务中取得较好的结果。但Transformer自身也存在一定的局限性,最主要的是注意力只能处理固定长度的文本字符串,这对于长文本来说会丢失很多信息。

参考文献 [1] Cho K, Merrienboer B V, Gulcehre C, et al. Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation[J]. Computer Science, 2014.

[2] 循环神经网络RNN

[3] 长短期记忆网络LSTM

[4] CNN在文本建模中的应用TextCNN

[5] Y. Kim, “Convolutional neural networks for sentence classification,” in Proceedings of EMNLP 2014

[6] 神经网络与深度学习

[7] Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate[J]. arXiv preprint arXiv:1409.0473, 2014.

[8] Attention注意力机制与self-attention自注意力机制

[9] The Illustrated Transformer

[10] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[11] 理解语言的 Transformer 模型

[11] transformer面试题的简单回答

[12] nlp中的Attention注意力机制+Transformer详解

[13] 深度学习中的注意力模型(2017版)

[14] Jimmy Lei Ba, Jamie Ryan Kiros, and Geoffrey E Hinton. Layer normalization. arXiv preprint arXiv:1607.06450, 2016.

[15] 模型优化之Layer Normalization

[16] 超详细图解Self-Attention

[17] 【经典精读】Transformer模型和Attention机制

[18] Transformer解析与tensorflow代码解读

返回列表 Bert预训练模型、Bert上搭建CNN、LSTM模型的输入、输出详解